それなりの立場にいる人が「あと数年でAGI完成すっぞ。あとさ、もしかしたら人類絶滅するかもしれんから気を付けてな」とか言うと本気でビビる。

Google DeepMind の主任 AGI 科学者は、今後 3 年以内に AGI が構築される可能性は 50% だと述べています。

これは彼が2011年に立てた予測を参考にしたものです。彼はまた、人間レベルの AI が構築されてから 1 年以内に人類が絶滅する確率が 5 ~ 50% あると考えていました。

平均的な研究者はAIが人類を絶滅させる可能性は16%あると考えている

Google の主任 AGI 科学者 Shane Legg: 3 年以内に AGI が実現する可能性は 50%、1 年後には絶滅する可能性は 5~50%

ラッセル氏:「[AI CEO]は、私たちの許可なく、全人類を相手にロシアンルーレットをやっている。」

「なぜ私たちは彼らにこんなことをさせているのか?」

「私は誰かが私の家に入ってきて、私の子供とロシアンルーレットをすることを許しません…あなたはどうですか?」

「超人的な存在が加わる世界へのこの差し迫った移行が、人類史上最大の出来事であるならば、それが起こるかどうか、またどのように起こるかについての決定に誰もが関与すべきであるように思われます。

現時点では、決定権を持つのは各社の CEO であり、彼らには既得権益があります。

彼らのうち数人は、人類が絶滅する可能性は10%か25%といったかなり高いと言っている。」

(ちなみに、スチュアート・ラッセルはAIに関する教科書を執筆しました)

注意 1: 2,778 人の AI 研究者を対象にした史上最大規模の調査では、平均的な研究者は AI が人類を絶滅させる可能性は 16% あると考えていました。

注意 2: アメリカ人の 82% は AI を停止または減速したいと考えています。

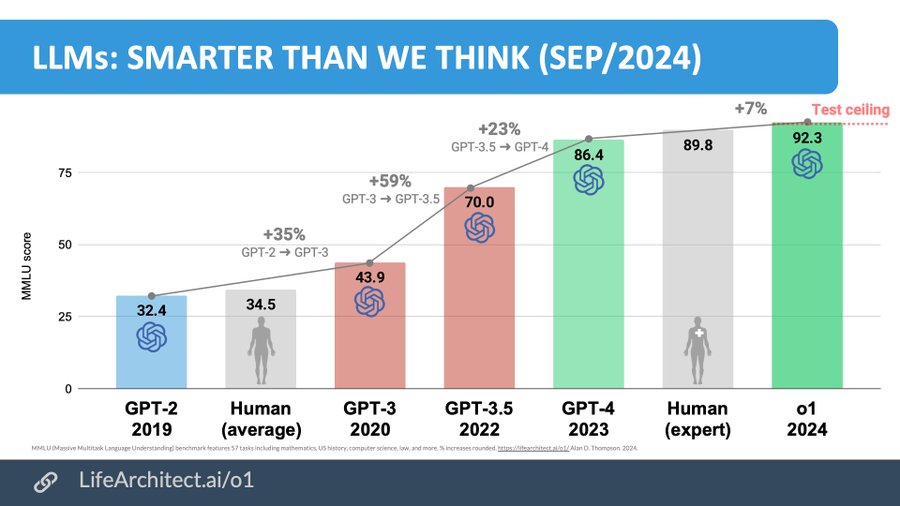

データを見れば、AIの指数関数的な能力向上は明らか

AIの能力の高さをIQで完全に測ることはできませんが、GPT-o1のIQはおおよそ133相当とされています。また、IQが150~160を超えると、単独で人類の行く末を変える可能性を持つのだとか。

その点、OpenAIからのリリースが予定されているo3は、流動性知能と直感においてIQ145〜150相当と見られており、ノーベル賞受賞者の領域に近付いているそう。

- IQの重要性: わずか10ポイントのIQの差が、能力のバランスに大きな影響を与える。

- o1のIQ: 人間換算でIQ約133と推定される。

- o3のIQ: GPT-4からの進化を考慮すると、IQ約145程度と推定され、これは「地球上のあらゆる問題を解決できる」レベル。

- 高IQのインパクト: IQ150〜160を超えると、人類の軌道を変える可能性を持つ。

- o3の能力: 流動性知能と直感においてIQ145〜150相当と見られ、難しい問題を非常に速く解決できる。

- 抽象化能力の進化: AIの抽象化能力は、GPT-2(ネズミ)からGPT-3(犬や猫)、GPT-4(賢い高校生)、そしてo1(平凡〜優秀な大学院生)へと進化。

- o3のレベル: o3は「平凡な大学院生よりもさらに一段上」で、「ノーベル賞受賞者の領域」に近づいている。

- データ重視: 著者はデータに基づいて分析を行っている。

- 複合的なベンチマーク: o1はMMLU、ARC-AGI、コーディングベンチマーク、GPQAなど、複数のベンチマークで優れた成績を収めている。

- AGIの可能性: o1の性能から、既にAGI(汎用人工知能)を超えている可能性がある。

- 指数関数的な進化: AIの能力は指数関数的に向上しており、データを見れば明らかである。

【知能爆発】人は、指数関数的な成長を直感的に理解できない

一般の人が考えるよりも──あるいは、AI研究のトップにいる人たちでさえ──AIの進化スピードずっと速く、もしかしたら、人には「指数関数的な成長」を直感的に理解することは難しいのかもしれません。

たとえ、AGIの実現が1週間後に迫っていても、ほとんどの人はそのことに気が付かない。ひょっとすると、すでにAGIが実現し、世界を大きく変えていたとしても、多くの人はそれに気が付かない可能性もある。

賢者たちの忠告を笑い飛ばした者たちは、嵐が過ぎ去った後に、その意味を悟るだろう。しかし、その時にはもう、後悔の涙で海を埋め尽くすことしかできないのだ。

特異点の特徴の 1 つは、予想よりも早く到来することです。人々は指数関数的な成長を直感的に理解しません。

直前まで、まだ何年も先のことのように感じられるでしょう。1 週間前でさえ、まだそう感じられるでしょう。それが知能爆発と呼ばれる理由です。爆発は段階的なプロセスではなく、1 秒ごとに発生します。